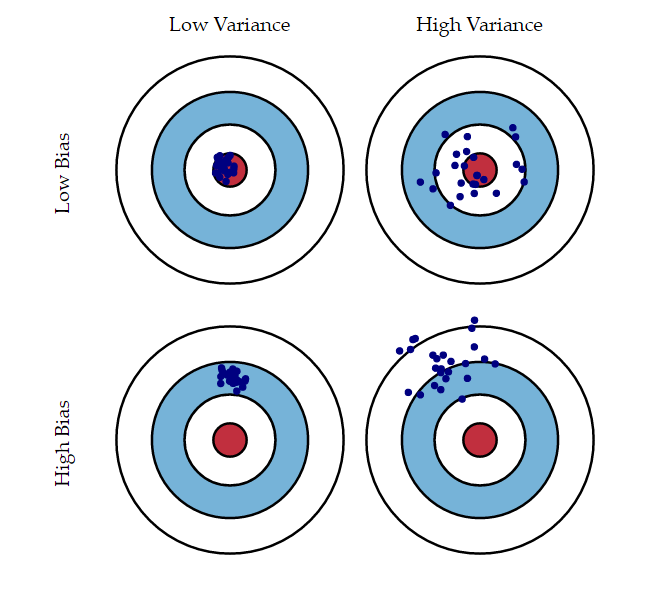

Quanto mais parâmetros colocamos no modelo, menor se torna o viés, porém mais complexo ele se torna e maior é a variância. Em machine learning é importante encontrar o equilíbrio entre viés e variância num modelo.

O trade-off entre viés e variância está relacionado aos conceitos de underfitting e overfitting.

Links:

- Data Hackers - Medium.com: https://medium.com/data-hackers/o-que-%C3%A9-bias-variance-tradeoff-a5bc19866e4b

- Wikipedia: https://en.wikipedia.org/wiki/Bias%E2%80%93variance_tradeoff

- Towards Data Science - Medium.com: https://towardsdatascience.com/balancing-bias-and-variance-to-control-errors-in-machine-learning-16ced95724db

- KDnuggets: https://www.kdnuggets.com/2016/08/bias-variance-tradeoff-overview.html

- Scott Fortmann-Roe: http://scott.fortmann-roe.com/docs/BiasVariance.html

- Data Science StackExchange: https://datascience.stackexchange.com/questions/34030/the-bias-variance-trade-off

- Stats StackEchange: https://stats.stackexchange.com/questions/336433/bias-variance-tradeoff-math